如何借助 LLM Gateway 同时接入多款 AI 大模型?

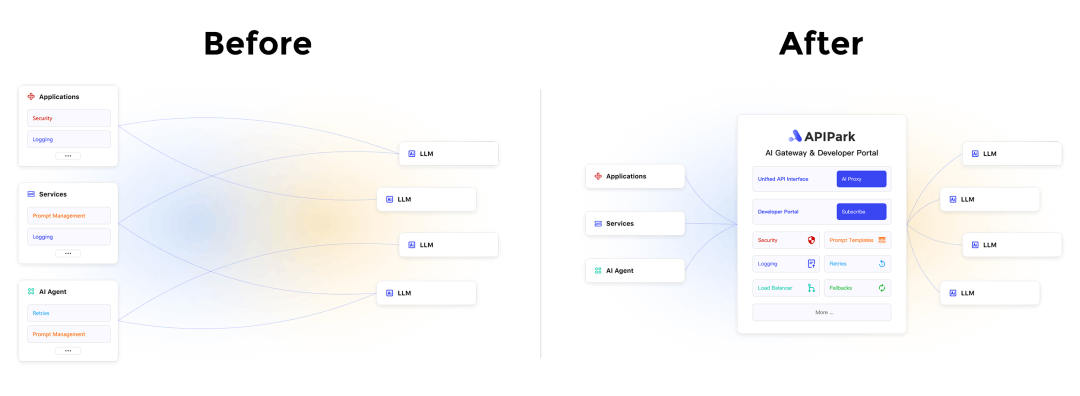

而不同 AI 供应商(包括开源和自托管模型)的 API 设计和调用方式不一致,导致了开发人员和企业使用和管理 AI 服务的方式变得非常复杂。

APIPark 为大家带来全新的 AI Service (AI Gateway / LLM Gateway )功能,支持快速同时接入多个 AI 大模型。

通过统一的 API 格式来简化调用过程,APIPark 极大地减少了模型切换的复杂性和不稳定性,并且支持将 Prompt 封装成标准 REST API,便于常用 API 的在团队内外部的复用共享。

此外,APIPark 还支持 API 全生命周期的管理,覆盖 从API 的设计、发布到调用和下线的全过程,同时还提供订阅审批机制,有助于提高数据安全性。

通过统一的 API 格式来简化调用过程,APIPark 极大地减少了模型切换的复杂性和不稳定性,并且支持将 Prompt 封装成标准 REST API,便于常用 API 的在团队内外部的复用共享。

此外,APIPark 还支持 API 全生命周期的管理,覆盖 从API 的设计、发布到调用和下线的全过程,同时还提供订阅审批机制,有助于提高数据安全性。

🚀极速接入多款大模型

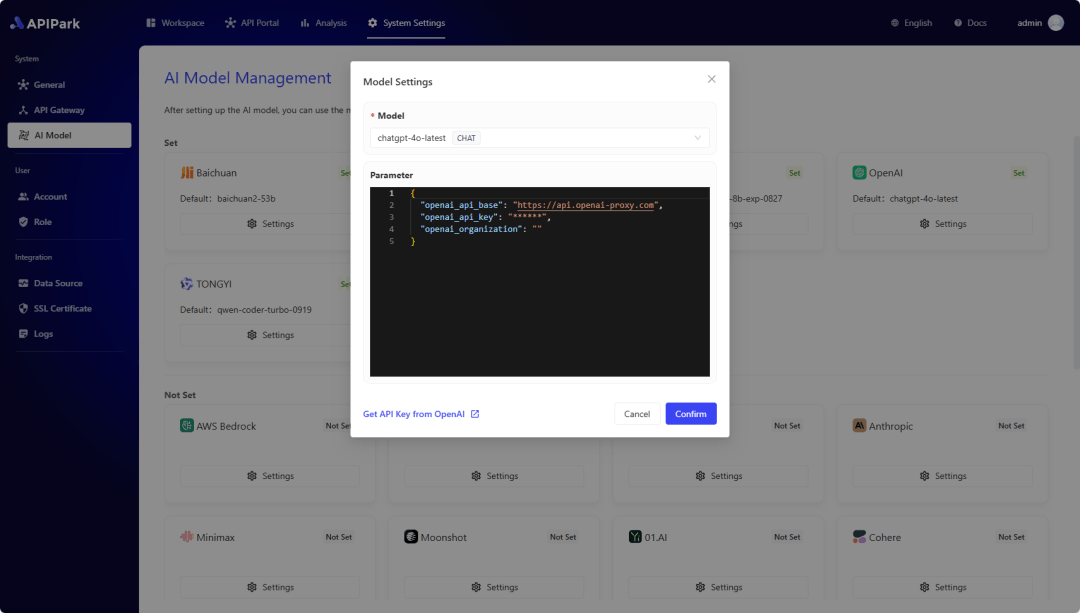

步骤1:配置 AI 大模型供应商

在开始创建 AI 服务之前,首先需要配置 AI 模型供应商。APIPark 支持多款主流 AI 大模型,包括 OpenAI、Anthropic、AWS Bedrock、Google Gemini ...

配置供应商后,您可以选择不同的模型来创建 AI 服务,并在 APIPark 中统一管理所有 AI 服务的授权信息和成本统计。

进入 系统设置 模块,在侧边栏中选择 AI 模型管理,在列表中可以看到 APIPark 支持的所有 AI 供应商。

💡 如果列表内没有您想要的AI 大模型,欢迎给我们提交 Issue(点击跳转)!

1)选择 默认的 AI 模型:后续在 AI 服务中创建 API 时,系统会自动为 API 设置默认的 AI 模型,减少用户操作的次数。

配置信息一般可以在供应商的 Open API 管理后台获得,你可以在弹窗左下角找到快速跳转到供应商官网的按钮。

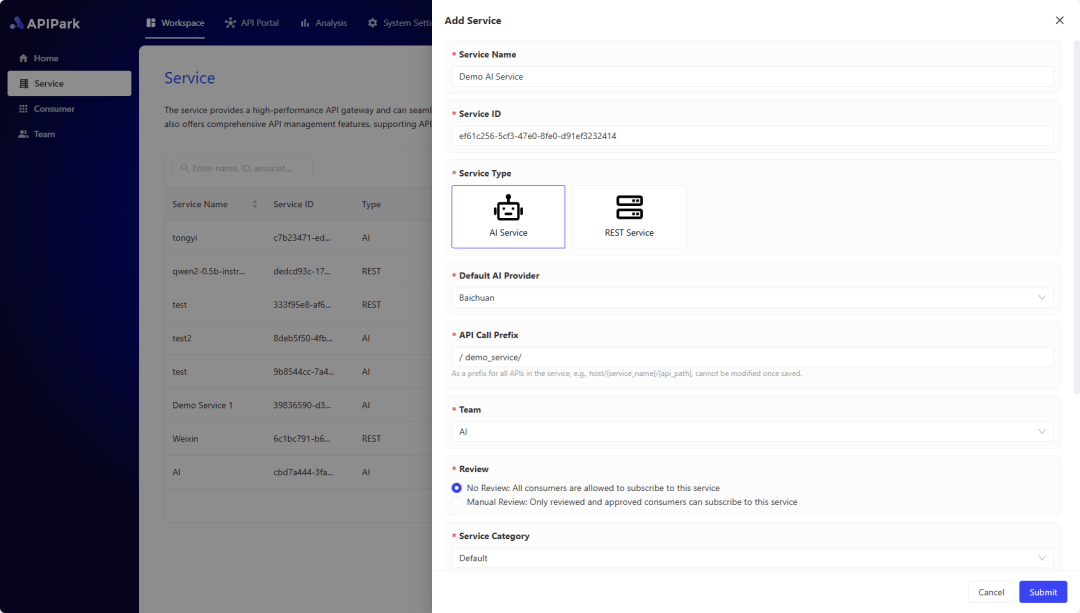

步骤2:创建并发布 AI 服务

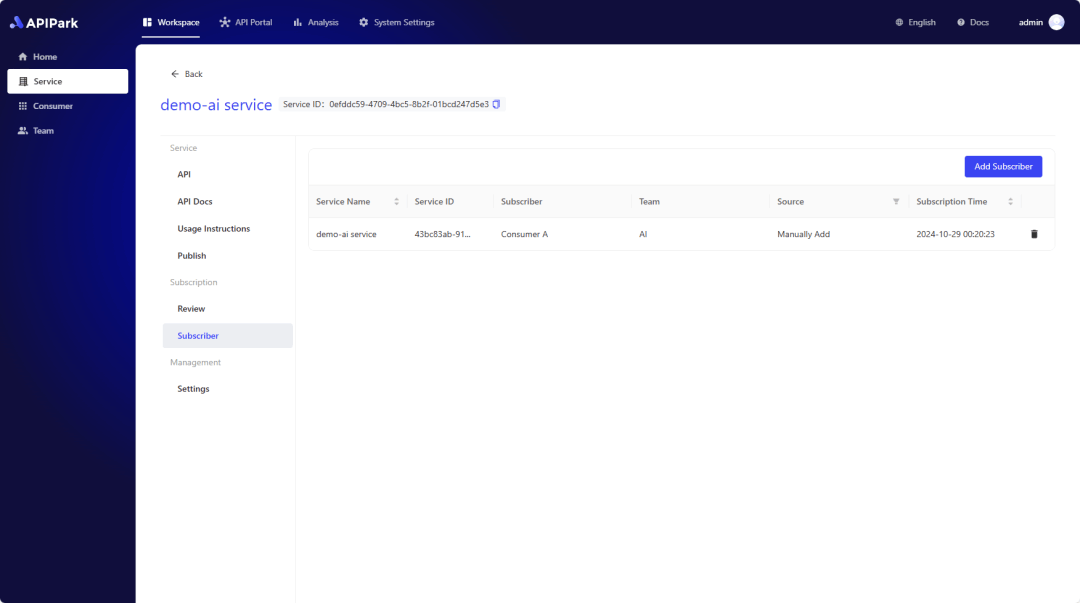

1)进入 工作空间 模块,在侧边栏中选择 服务,然后 创建服务,填写 AI 服务的基本信息、配置管理权限和订阅审核形式。

2)创建服务之后,APIPark 会自动在服务里创建一个默认的 聚合 API(Unified API),你可以直接通过这个聚合 API 来调用 AI 服务。

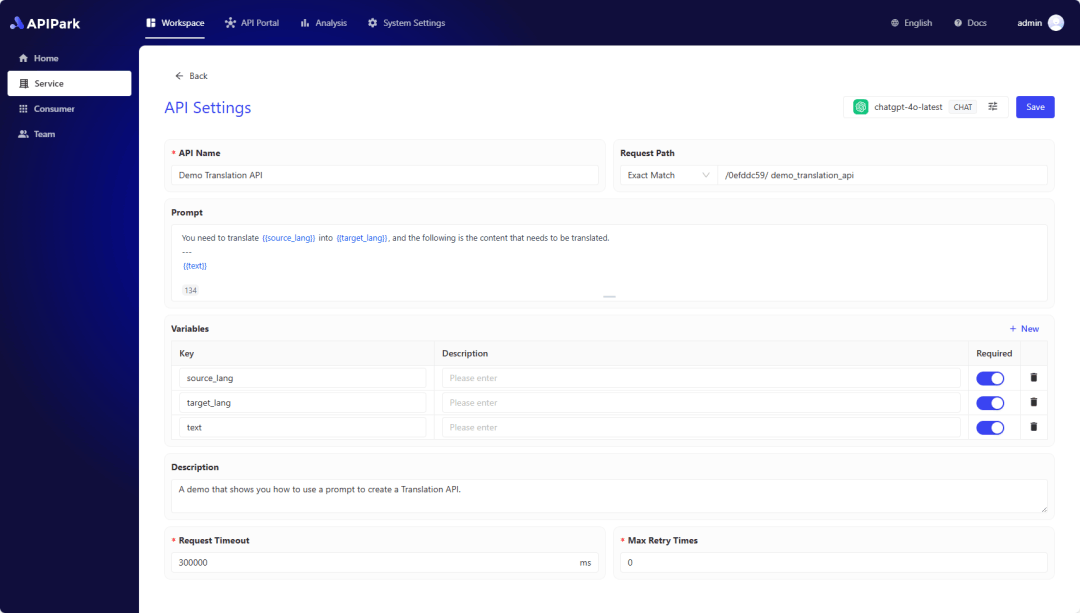

以往企业调用 AI 过程中,涉及到 Prompt 提示词都是采用硬编码的形式写在系统中。在 APIPart 上你可以对每个 LLM API 的 Prompt 独立管理,你可以将 Prompt 提示词和 AI 模型组合成自定义的 AI API 。

3)将配置了 Prompt 的 AI API 发布到 API 门户上供大家订阅; 你可以给 API 配置审核流程,团队内外的开发者需要等待审核通过之后才能调用, 你还可以在列表中看到所有订阅该服务的 消费者。

更多推荐

已为社区贡献116条内容

已为社区贡献116条内容

所有评论(0)